10月24日,以致敬AI開發者為主題的人工智能盛會——第二屆世界聲博會暨2019科大訊飛1024全球開發者節隆重開幕。大會設立了24場分論壇詳解全域AI,聚集120多位AI前進者發表主題演講,且擁有10000多平方米的生態伙伴AI產品展區。本屆盛會受到海內外智能產業從業者和愛好者高度關注,超過1.4萬開發者們齊聚一堂,為期三天的活動,預計吸引線上線下共105萬AI愛好者共赴這場AI追光之旅。科大訊飛董事長劉慶峰、輪值總裁胡郁、京東物聯總裁周炯等蒞臨大會并發表主題演講。

作為科大訊飛智能汽車戰略合作伙伴,自行科技受邀參會。公司聯合創始人兼CEO關艷峰博士出席并發表“智能座艙多模態感知與融合”主題演講,從智能座艙演進、多模態感知與融合、智能座艙應用及未來發展趨勢等多個角度闡述了其對智能座艙的深度洞察,并分享了公司在智能座艙多模態感知融合、ADAS+DMS+HMI、人臉+語音解鎖車門等方面的應用與落地。以下是關艷峰博士觀點整理——

AI感知技術為智能座艙賦能

人工智能時代到來,為汽車產業不斷創造了新的價值同時也帶來了新的挑戰,汽車智能化、網聯化愈發明顯。汽車座艙作為人車交互的接口,也將被賦予更大的意義。傳統座艙軟硬件非常分散,零部件多,但是互動性和同步協作性不強,導致座艙內信息非常碎片化,對于人機交互非常不友好,體驗感不強,智能性不強,因此無論是OEM還是消費者都希望能用一種更加智能的新一代座艙來搭建人車之間的溝通橋梁。

汽車座艙發展可以分為四個階段:傳統座艙、信息座艙、智能座艙與無人駕駛座艙。傳統座艙以指針儀表、按鍵開關為主,設計相對簡單。信息座艙增加了液晶儀表、娛樂導航、T-Box等新的信息呈現設備,座艙內信息內容更豐富,智能化能力初步顯現。智能座艙則在信息座艙的基礎上增加了對駕駛員和乘客的語音、圖像、手勢及整車智能(ADAS/DMS)等方面的感知,通過多模態信息感知與融合,為消費者提供智能化輔助和服務。無人駕駛座艙則是座艙發展的終極目標,座艙可能會具備智能自我提升能力,能夠對人/車/環境等進行深度融合,座艙結構布局也將會發生重大變化。

今天重點探討未來幾年內就有可能普遍落地的汽車座艙——智能座艙。智能座艙不僅需要座艙能夠對車輛和道路環境進行實時感知,還需要能智能感知駕乘人員的狀態信息,智能座艙中的智能化技術將是汽車座艙實現智能化最關鍵的技術之一。不同于以往座艙,智能座艙不僅要從車輛本體和網絡上獲取信息,更要從駕駛員、乘客以及車外環境中感知更多更復雜的信息,通過語音識別、圖像識別、手勢識別、行為識別等多種AI技術,為駕乘人員提供智能化、個性化的新型服務。

但是,當前大部分智能座艙產品存在一個問題:雖然智能座艙上配備了越來越多的傳感器,但是幾乎都是單模態感知、單獨交互,獨立工作,彼此間的關聯性不強,大大降低了信息感知的價值。因此我們希望能夠改善這些問題,也就是我今天要說的多模態感知與融合。

多模態感知融合讓座艙更智能、更懂你

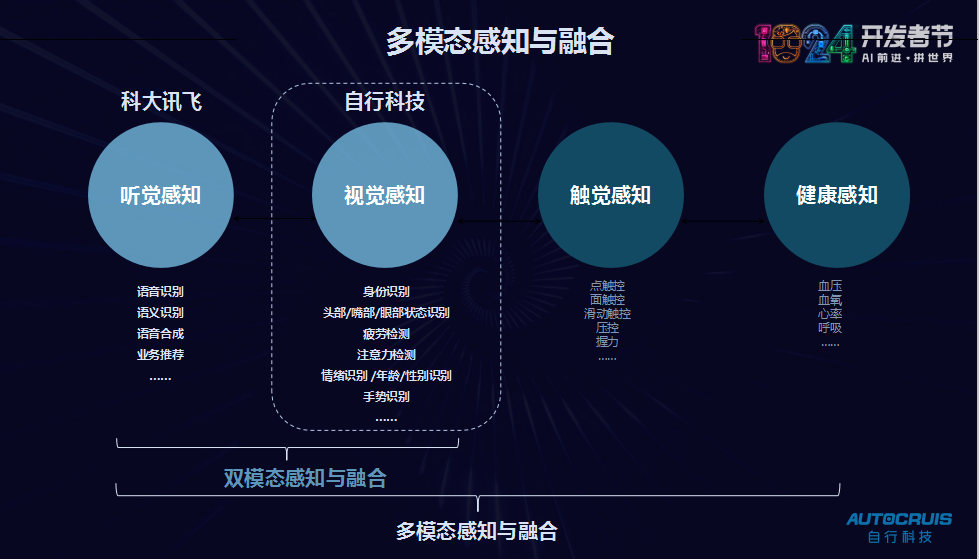

多模態感知(融合)是多種傳感器信息的深度融合,目的就是實現1+1>2的效果,它可以實現更精準、更高可信度的感知,進而提供更好的信息和服務,包括類別、語義、行為、精度等等。在當前感知技術中,語音與圖像識別是感知座艙駕乘人員與環境信息最有效的方式,因此,語音與圖像的感知融合就非常重要和必要。

自行科技是一家以AI與嵌入式技術為核心的新型智能汽車電子服務商,是中國駕駛員監控國家標準制定成員企業和Bosch中國、豐田通商、Xilinx、華為(Hicar)的戰略合作伙伴。公司以車內與車外短中長距離視覺感知與融合技術為核心,為前裝乘用車與商用車廠提供前向ADAS、駕駛員監控、智能全景影像、盲區檢測、智能座艙系統等車內外一些列的感知模組與系統,開發出國內首款基于深度學習技術的駕駛員監控系統,在圖像識別、語音與圖像感知融合、視覺與毫米波雷達融合等領域有多年的技術積累。

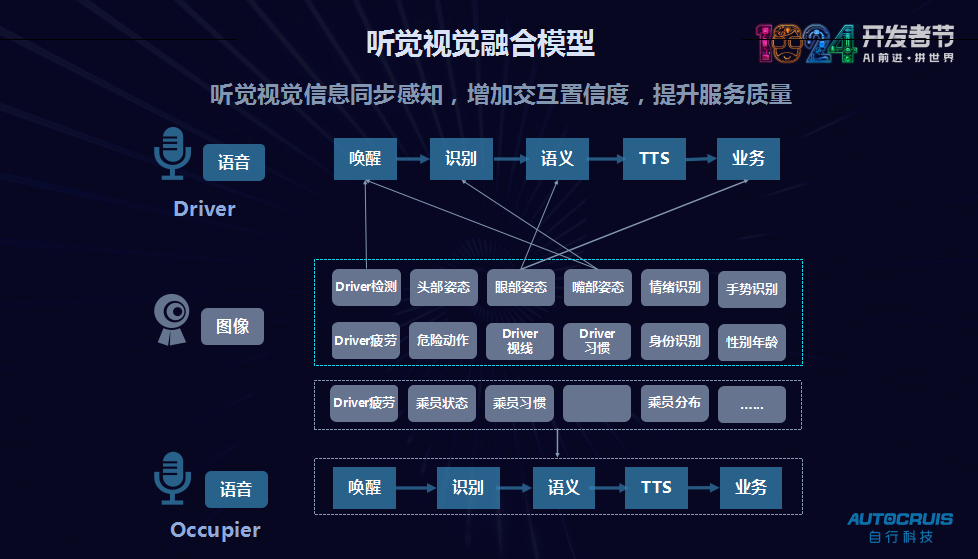

自行科技聽覺視覺融合模型

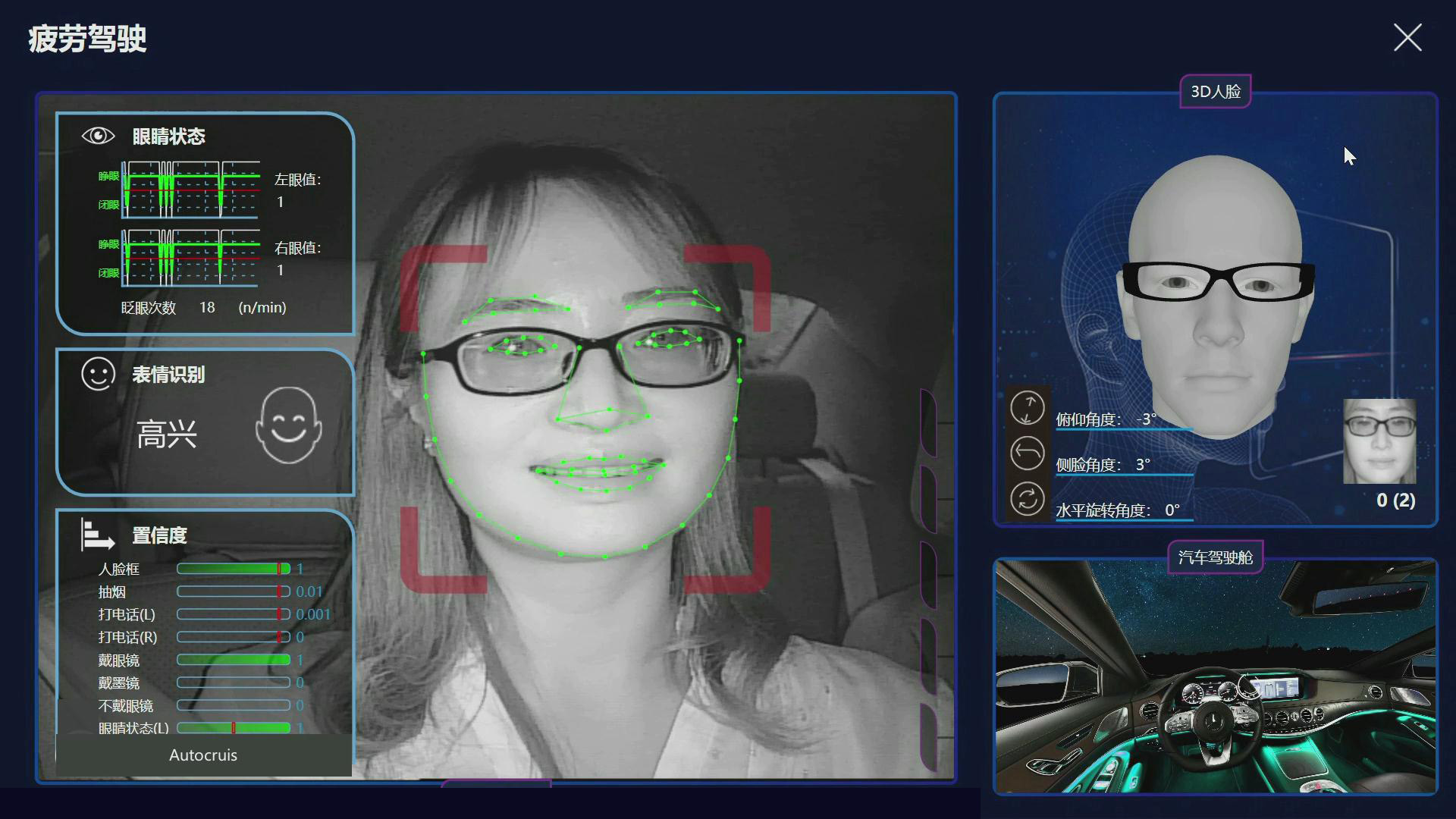

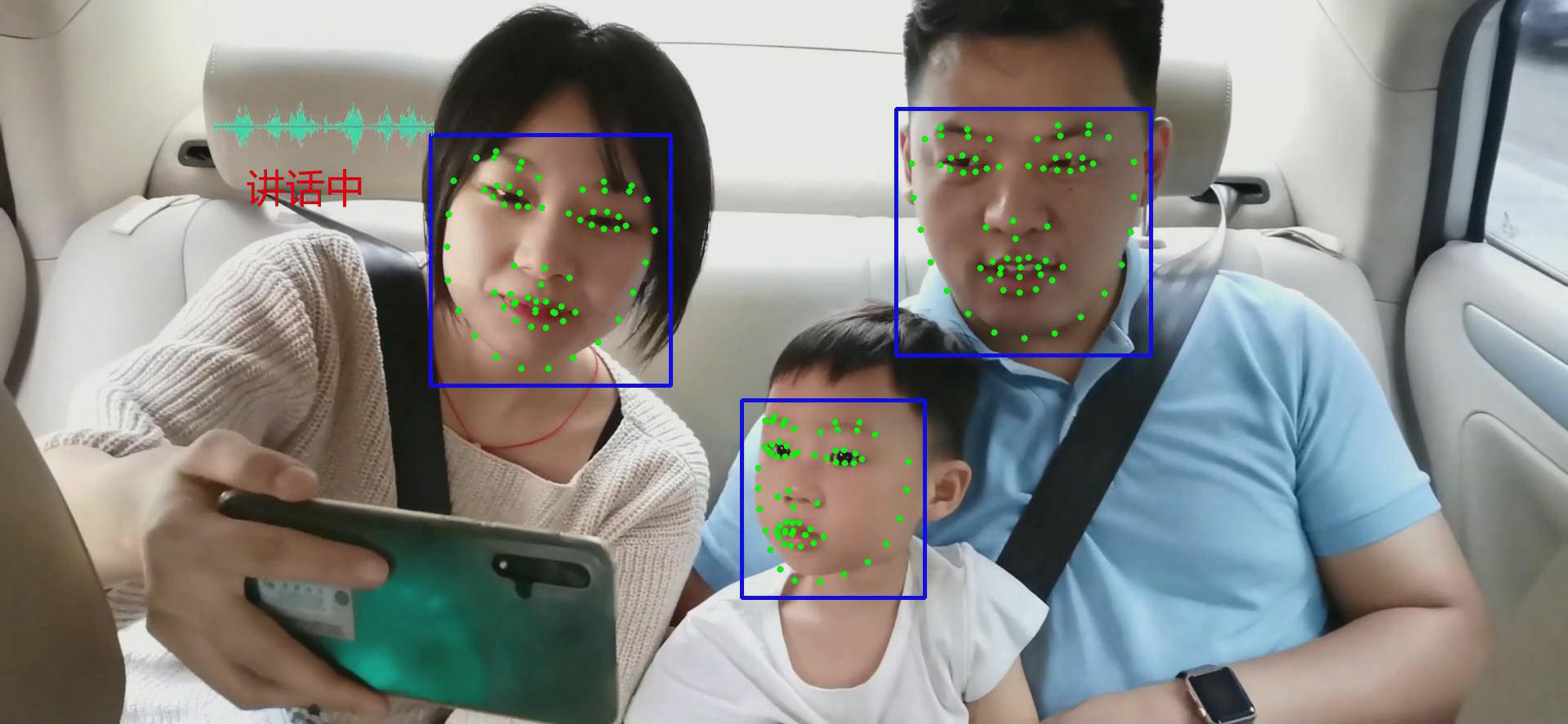

自行科技融合方案通過視覺感知與語音融合技術,同步獲取駕乘人員圖像與語音信息,深度融合圖像語音信息,更精準地獲取駕乘人員地身份、意圖、情緒、方位等信息,為其提供更好的智能化輔助與服務。通過深度學習技術,公司對駕乘人員進行面部特征點檢測(眼睛狀態/視線/嘴型/表情/年齡/性別等)、頭部姿態三軸估計、行為檢測,結合語音識別、語音識別、語音合成、TTS等語音識別技術,深度融合語音圖像信息,基于融合判斷策略決定后續業務和功能觸發,增加交互可信度。

自行科技語音視覺融合方案

舉個例子,公司通過車內感知技術,不僅可以精準感知駕駛員身份、疲勞、分心、危險動作、情緒、視線、、年齡、性別等信息,還可以對全車艙乘客與環境進行實時感知,包括對副座、后排乘客(兒童)進行人臉、年齡、性別、嘴型、落座情況、異常行為進行檢測,通過圖像識別與語音信息融合,快速判斷目標是否講話,是否需要進行語音喚醒等,提高在嘈雜環境下人機交互體驗。

自行科技后排乘客檢測方案

在語音圖像信息融合的過程中,數據的同步和匹配非常關鍵。如果兩類信息不能同步,那么容易產生錯誤的匹配,反而容易給用戶造成困擾。第二個就是數據如何匹配,單模態數據都會產生判斷,我們該如何判斷哪類信息準確,哪類不準確,多模態融合應該如何進行邏輯判斷,如何最終為用戶提供更精準的判斷結果。在這里,自行科技基于視覺感知數據進行了3.5級結構化數據分類,從功能大類、功能小類、特征指標及其它們的重要性都做了系統的區分,為客戶提供系統的,完整的,可深度融合的感知數據結構。

當然,公司也在其他多模態融合技術上進行了深度開發,比如公司與國內知名乘用車OEM提供整套人臉解鎖車門方案,通過對人臉識別、人臉防偽檢測、語音識別和解鎖觸發,可在100ms內快速識別駕駛員身份后智能解鎖車門,為用戶提供高效精準的智能服務。同時,公司也基于前向ADAS系統、駕駛員監控系統、語音識別技術為客戶提供個性化HMI(顯示)開發,從視覺感知、語音識別、視覺呈現等多方面提供智能座艙多模態交互。

結語

隨著人工智能、自動駕駛和5G等技術的快速發展,智能座艙將會集成ADAS、IoT、V2X等新興技術,從硬件模塊、感知信息、交互方式等多維度進行深度融合,成為整車實現信息化、安全化、舒適化、無人化的重要部件。智能座艙將會讓整車系統更加智能,更懂你,具備更高的情商,實現人車合一,進而成為新一代的人車智能移動空間,真正成為人類的第二空間。